Performances clés du Nvidia H100 pour l’entraînement IA génératif multimodal

Le GPU Nvidia H100 est conçu spécifiquement pour répondre aux exigences extrêmes des modèles d’IA générative multimodale. Avec 80 Go de mémoire HBM3 et une puissance de calcul de 4 petaFLOPS en précision FP8, il maximise le débit de calcul et facilite la gestion de modèles complexes.

Cœurs Tensor de quatrième génération

Cette nouvelle génération de cœurs tensoriels multiplie par six la vitesse d'entraînement et triple la capacité d'inférence comparé au modèle précédent, l’A100. Cette accélération est particulièrement profitable pour des réseaux de neurones profonds impliqués dans le traitement combiné de texte, images et autres modalités.

Moteur dédié aux transformateurs

Le H100 intègre un moteur spécialisé pour l’accélération des tâches de NLP et vision, optimisant le traitement des tokens par seconde. Il s’agit d’un différenciateur majeur pour les performances sur les modèles de langage et les architectures multimodales.

Réduction des temps d’entraînement

Grâce à ces avancées matérielles et logicielles, le H100 permet de réduire les durées d’apprentissage des modèles jusqu’à trois fois, offrant un avantage stratégique pour la R&D et la mise sur le marché rapide des solutions IA.

Benchmarks MLPerf

Les évaluations MLPerf confirment que le H100 est deux fois plus rapide que l’A100 pour l’entraînement des grands modèles de langage (LLMs) tout en maintenant une précision optimale grâce à la gestion avancée du FP8(1).

Scalabilité avancée via NVLink 4.0 pour réduire les temps d’entraînement

Le Nvidia H100 se distingue aussi par sa capacité à supporter des clusters de GPU étendus. La technologie NVLink 4.0 permet d’interconnecter les cartes avec une bande passante GPU-GPU jusqu’à 900 Go/s, doublant ainsi les performances de communication internes par rapport aux générations précédentes.

Clusters GPU puissants

Les clusters classiques vont de 4 à 8 GPU, mais il est possible de s’étendre à plusieurs milliers d’unités. Cette topologie améliore drastiquement la vitesse d’entraînement sur des modèles multimodaux de plusieurs milliards de paramètres, souvent incompressibles autrement.

Communication optimisée

La combinaison d’une topologie NVLink intra-nœud et d’interconnexions multi-nœuds via InfiniBand ou RoCE à très haut débit réduit nettement les goulets d’étranglement, garantissant un entraînement fluide et progressif même à grande échelle.

Système HGX H100

La plateforme HGX avec jusqu’à huit H100 interconnectés maximise la scalabilité et permet de ramener les durées d’entraînement traditionnelles de plusieurs semaines à quelques jours, un critère devenu essentiel dans la compétitivité du secteur.

Optimisation du débit de tokens

Enfin, les stratégies pour optimiser le débit de tokens par seconde dans ces clusters assurent une précision maintenue et une efficacité d’entraînement à la fois robuste et régulière(2).

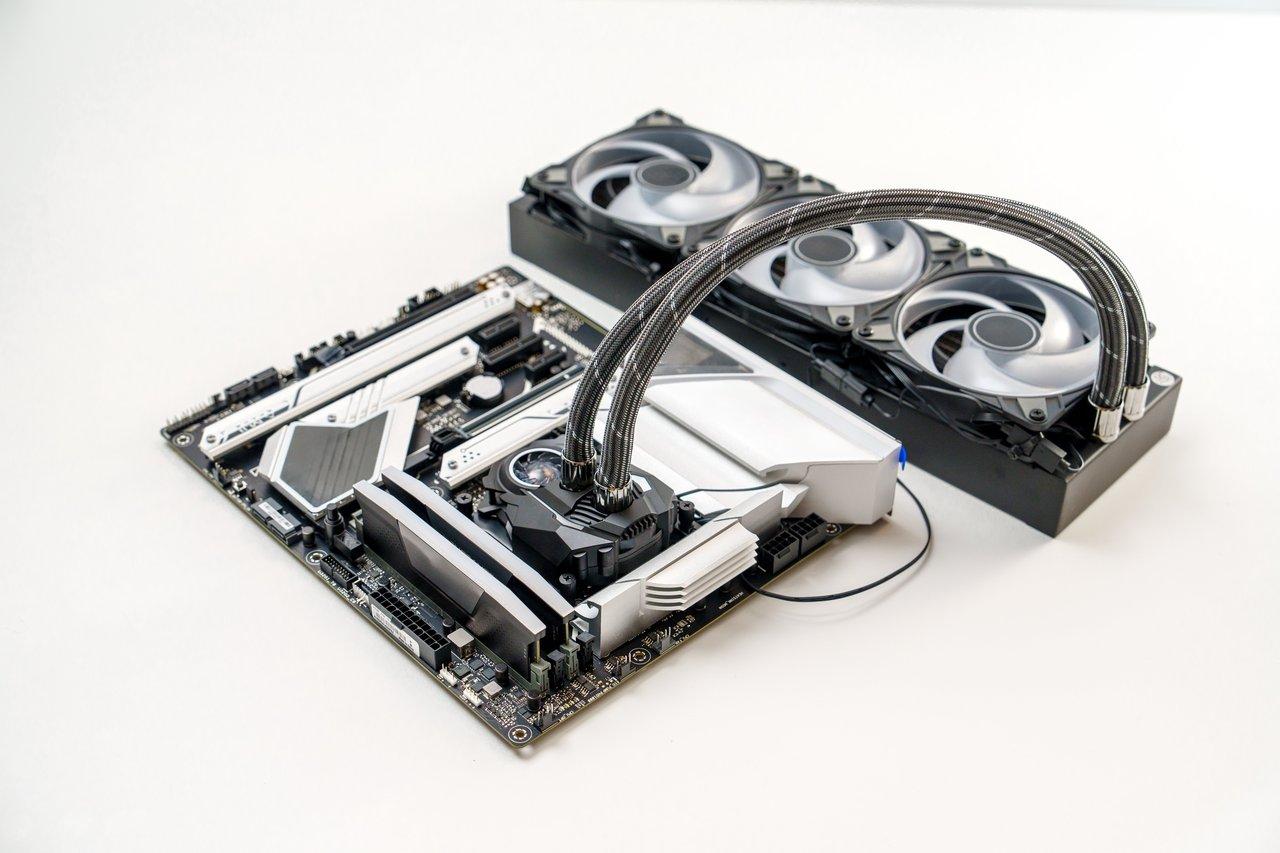

Consommation énergétique et gestion thermique du Nvidia H100

La puissance du H100 s’accompagne d’une consommation électrique conséquente, autour de 700 watts. Cette exigence énergétique nécessite un système de refroidissement performant, souvent liquide, pour garantir la stabilité des opérations sur des entraînements prolongés.

Sur le plan de l’efficacité, le H100 affiche une efficacité énergétique supérieure à 20 TFLOPS par watt, doublant celle de ses prédécesseurs, ce qui rend possibles des entraînements intensifs sur la durée sans exploser la facture énergétique.

Un refroidissement liquide efficace peut réduire les coûts énergétiques jusqu’à 20 %, un facteur important dans la gestion budgétaire, notamment sur des clusters modernes où les consommations cumulées sont élevées.

Sur le long terme, l’arrivée de l’architecture Blackwell promet de diviser par 25 la consommation énergétique en inférence, un changement qui devra être intégré dans les calculs TCO futurs.

La planification des infrastructures doit donc prendre en compte les besoins en refroidissement, coût d’installation et maintenance, car ils impactent directement la rentabilité de l’investissement(1).

Comparatif du Nvidia H100 avec AMD MI300X/MI325X et Intel Gaudi3 pour l’entraînement multimodal

Le marché propose des alternatives solides au Nvidia H100, notamment avec AMD et Intel, qui répondent à divers besoins de budgets et d’infrastructures :

| Caractéristiques | Nvidia H100 | AMD MI300X/MI325X | Intel Gaudi3 |

|---|---|---|---|

| Capacité mémoire | 80 Go HBM3 | Jusqu’à 256 Go HBM3E | 64 Go HBM |

| Efficacité énergétique | 20 TFLOPS/watt | 20-30% de gain sur TCO | Supérieure de 50% au H100 (BF16) |

| Budget approximatif | ~40 000 € | 25 000 - 28 000 € | ~20 000 € |

| Écosystème logiciel | CUDA, TensorFlow, PyTorch (mature) | ROCm (moins mature) | Support BF16, open-source friendly |

| Cas d’usage recommandés | Largeurs et précisions élevées, clusters massifs | Grands clusters avec besoins mémoire | PME, projets open source, BF16 ciblé |

Le Nvidia H100 reste la référence absolue pour les modèles très larges à haute précision et la scalabilité éprouvée. Cependant, AMD et Intel apportent des alternatives pertinentes selon contraintes budgétaires et besoins spécifiques(3).

Bonnes pratiques pour optimiser le temps d’entraînement et le ROI avec le Nvidia H100

Pour tirer pleinement parti du Nvidia H100, certaines recommandations guident les choix stratégiques en entreprise :

- Ne pas surdimensionner : réserver le H100 aux modèles volumineux. Pour les tâches plus légères, les GPU RTX 4090 ou 5090 offrent un meilleur rapport performance/coût et une consommation moindre.

- Exploiter pleinement NVLink : mettre en place des clusters bien configurés pour maximiser la scalabilité sans engorger les communications GPU-GPU.

- Préférer un refroidissement liquide afin de réduire la consommation énergétique et assurer la stabilité thermique, particulièrement sur les entraînements prolongés.

- Utiliser un harnais de test de plusieurs centaines d’étapes d’entraînement pour mesurer avec rigueur les performances et détecter les seuils d’efficacité en configuration uni et multi-GPU.

- Intégrer l’ensemble des coûts (hardware, énergie, refroidissement) dans la gestion budgétaire pour garantir un ROI supérieur à 200 % sous 12 mois pour les PME, grâce à la réduction des délais et coûts opérationnels.

- Maintenir les frameworks à jour (CUDA, TensorFlow, PyTorch) afin de bénéficier des optimisations continues et maximiser les gains en vitesse et précision.

Adopter ces bonnes pratiques assure non seulement d’accélérer les projets IA mais également de maîtriser durablement les dépenses et les performances.

Sources

- eurocapa.com - https://www.eurocapa.com/blog/guide-gpus-ia-2025-cartes-graphiques-b2b

- fibermall.com - https://www.fibermall.com/fr/blog/nvidia-hgx-h100.htm

- sinsmarts.com - https://www.sinsmarts.com/fr/blog/best-gpus-for-ai-training-in-2025-expert-picks-buyer-s-guide